AI Agent 在药物警戒领域的应用、GCP 规范及企业合规使用指南

AI Agent 在药物警戒领域的应用、GCP 规范及企业合规使用指南

关键要点

- 研究表明,AI Agent 可显著提升药物警戒(Pharmacovigilance,简称 PV)效率,例如自动化不良事件检测和信号分析,潜在提升 40-60%,但人类监督至关重要,以确保准确性。

- GCP 规范(ICH E6(R3) 更新版)将 AI 视为计算机系统的一部分,要求进行验证、风险管理及比例化方法,但未制定 AI 专用规则,重点强调技术需适合用途并保护参与者安全。

- 证据倾向于,企业可在合规前提下使用 AI Agent,通过采用风险为基础的方法、确保透明度、数据质量,并与 FDA 和 EMA 等机构法规对齐,同时处理偏差和伦理问题。

- 证据显示,需持续监控和验证 AI 模型,以缓解算法偏差等风险,CIOMS 等框架提供最佳实践指导。

AI Agent 在药物警戒中的概述

AI Agent 是自主决策和适应的系统,在药物警戒中用于处理海量数据,如患者报告、社交媒体和电子健康记录,帮助更快、更准确地检测不良事件。例如,AI 可自动化病例处理,减少时间高达 60%,让人类专家专注于复杂判断。然而,使用需平衡创新与安全,避免过度依赖导致错误。

GCP 规范与 AI 整合

良好临床实践(GCP)提供临床试验的伦理和质量标准,包括与药物警戒重叠的安全监测。最新 ICH E6(R3) 指南(2025 年生效)将 AI 视为需验证的计算机系统,强调风险评估和监督,以确保数据可靠性和参与者保护。这意味着试验中的 AI 工具需测试一致性,并提前处理数据泄露等风险。虽然 GCP 无 AI 专用规则,但它促进比例化方法,适应 AI 等技术以提高试验效率,同时不损害伦理。

企业合规使用 AI Agent 的策略

制药企业可通过风险为基础框架部署 AI Agent:根据对患者安全和监管决策的影响分类应用,然后实施人类监督和模型透明等控制。例如,从低风险任务如数据提取开始,确保训练数据多样化以避免偏差,并记录一切以便审计。及早与监管机构互动,如 FDA 的 AI 理事会或 EMA 的建议,有助于遵守 GDPR 等数据隐私要求。这种方法促进信任和创新,同时优先考虑患者福祉。

人工智能(AI)Agent 作为自主系统,能够进行决策和适应,正在药物警戒(PV)领域发挥变革作用,即监测批准后药品安全的过程。这些 Agent 超越传统 AI,能够主动管理药物安全监测的工作流程。本概述全面探讨其应用、与良好临床实践(GCP)规范的整合、监管框架、挑战及企业合规采用策略,基于 EMA、FDA、ICH 和 CIOMS 等权威来源的指南。

AI Agent 在药物警戒中的应用

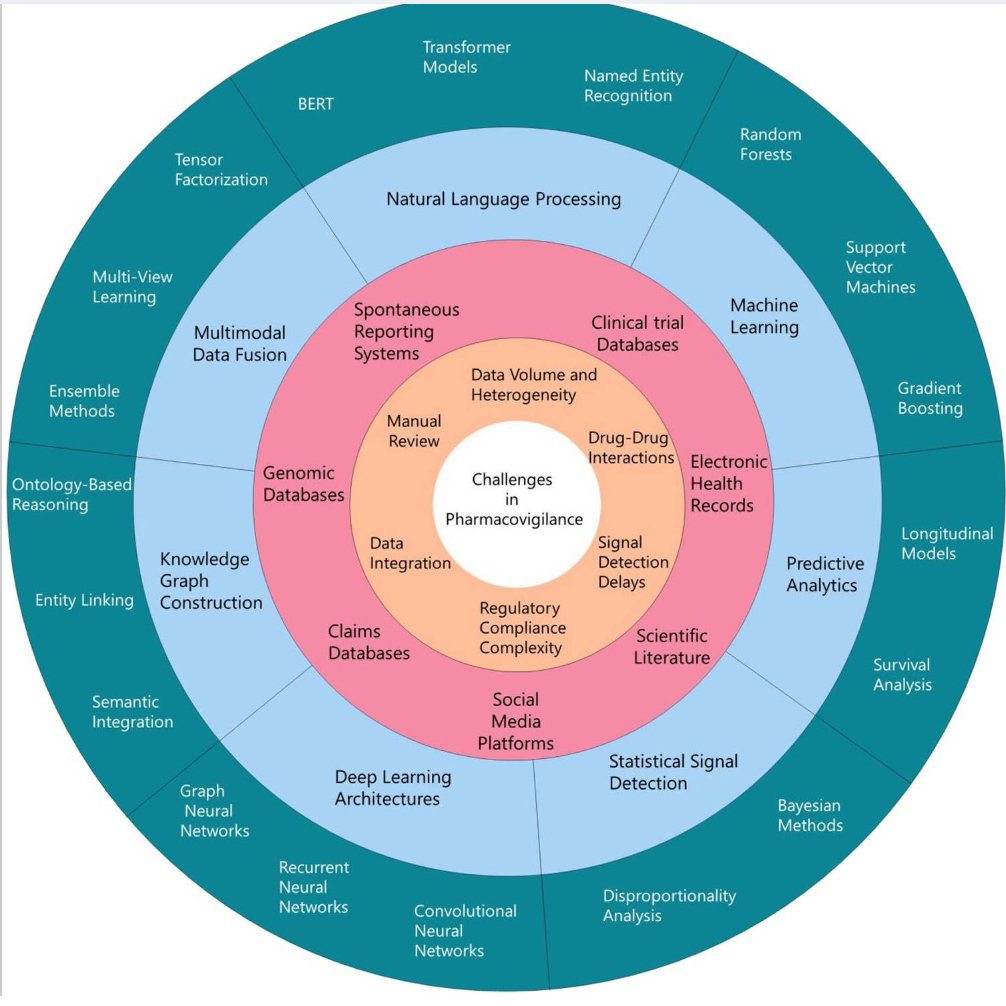

AI Agent 通过自动化重复任务、实现主动安全监测并整合多样数据源来优化 PV。例如,它们使用自然语言处理(NLP)和机器学习(ML)从非结构化数据(如患者报告、电子健康记录和社交媒体)中提取并分类不良药物反应(ADR)。例如,MADEx 等模型在识别临床笔记中的 ADR 时准确率高达 AUC 0.99,处理时间减少 40-60%。 Agent 可处理病例去重,精确度超过 95%,使用概率链接和网络分析,每天处理数千提交。

在信号检测和监视方面,Agent 采用贝叶斯网络和梯度提升机(AUC 0.95),分析多模态数据,比传统方法提前 7-22 个月识别模式。 示例包括 FDA 的 Sentinel 系统或 CDC 的疫苗安全数据链,其中 Agent 通过快速循环分析标记潜在风险。

因果评估和预测中,AI Agent 使用决策树和 ML 预测药物-事件对的因果关系,敏感度高达 0.900,预测值 0.778,适用于多药联用场景。 专用于视网膜病变预测的 Agent(AUC 0.97)使用深度学习进行临床预防。

操作效率方面,Agent 自动化翻译(BLEU 分数 ≥0.6,覆盖 16 种语言)、SQL 查询生成(准确率高达 78.3%)和文档检索,减少努力 30%,同时保持 100% 人类质量控制。

未来应用可能涉及处理社交媒体数据的歧义,并创建肿瘤学等治疗领域的专家系统,将 PV 转向预防性和自检测模式。

以下表格总结 AI Agent 在 PV 中的关键用例,包括技术与益处:

| 用例 | 涉及技术 | 益处 | 实施示例 |

|---|---|---|---|

| 数据提取 | 大语言模型(LLM,如 GPT-4)、NLP | 效率提升 39%,每例减少 20 分钟 | 扫描文档、临床研究 |

| 病例去重 | ML、概率链接 | 精确度 95-100%,F 值 >0.9 | AWS 集成系统,每日提交 |

| 信号检测 | 贝叶斯网络、梯度提升 | 提前检测(7-22 个月更快) | FDA Sentinel、知识图谱 |

| 因果评估 | 决策树、ML | 敏感度 0.900,PPV 0.778 | 上市后征集病例 |

| 实时监测 | 深度学习、支持向量机 | AUC 0.97,敏感度 95% | EHR、社会媒体 ADR 识别 |

图 1:药物警戒中的挑战、数据源及相关 AI 技术综合概述,使用同心圆表示 PV 生态系统的不同层级。

GCP 规范及其与 AI 在 PV 中的关系

GCP 如 ICH E6(R3)(2025 年 1 月最终版)所述,提供临床试验的统一标准,延伸至与 PV 交叉的安全监测。 虽然非 AI 专用,但 GCP 通过以下方式处理 AI:

计算机系统验证:AI Agent 被视为需风险为基础验证的计算机系统,确保完整性、准确性和可靠性,包括从设计到退役的全生命周期管理,并为审计提供文档。

风险管理和监督:比例化、风险为基础的方法要求识别对参与者安全和数据完整性的影响。申办方需监督 AI 使用,包括分散试验中,针对高风险应用采用人在回路。

数据完整性和伦理:GCP 强调参与者中心实践,要求 AI 与知情同意和数据隐私原则对齐,与 PV 整合用于试验后安全。

在 PV 语境中,GCP 与良好药物警戒实践(GVP)重叠,确保 AI 支持伦理试验行为和可靠结果。

监管框架与合规策略

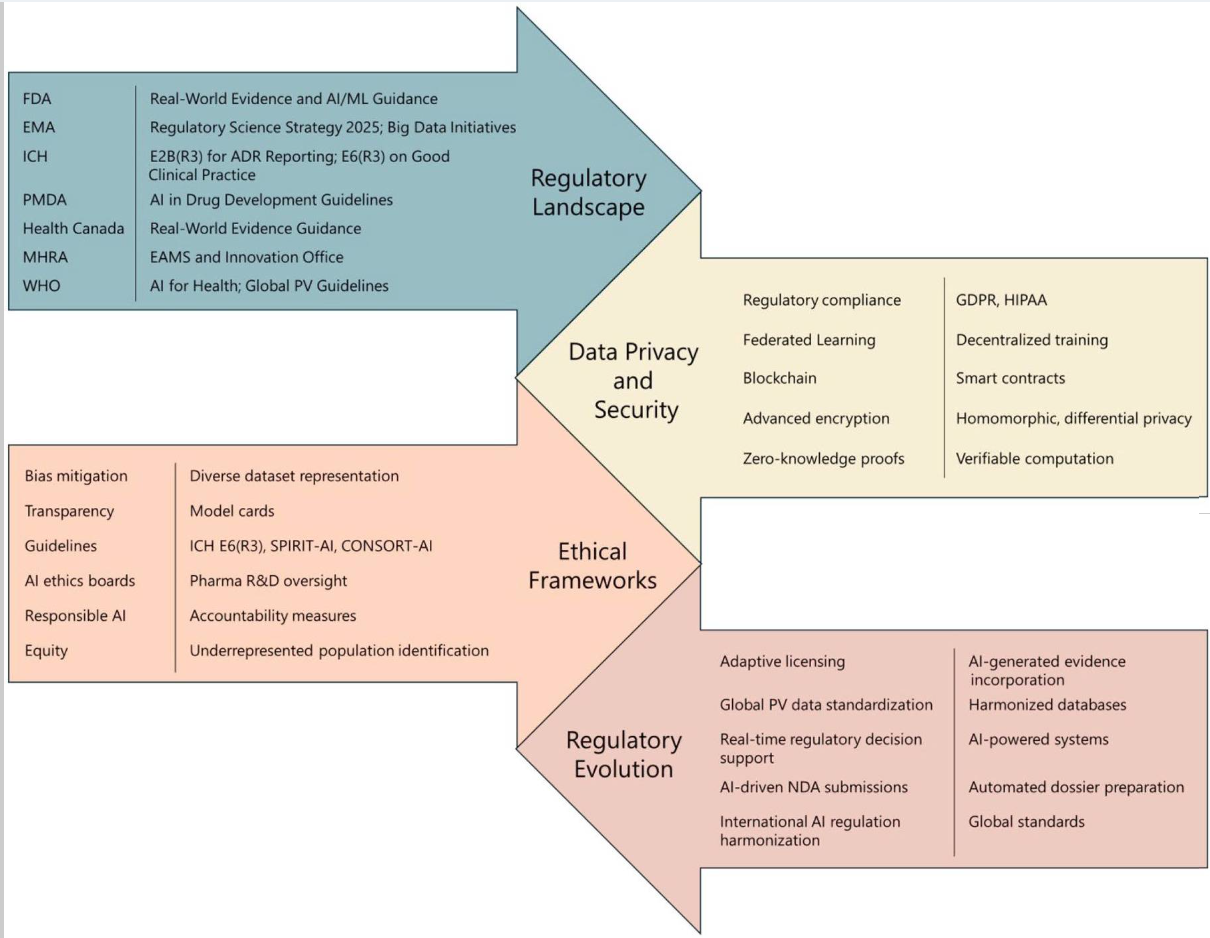

监管机构强调 PV 中可信 AI,框架聚焦透明度、问责制和患者安全。

EMA 指南:2024 年反思论文采用风险为基础方法,用于产品生命周期中的 AI,根据患者风险和监管影响分类。高风险 PV AI(如信号检测)需完整文档、人类监督和可解释工具如 SHAP 或 LIME。 合规涉及早期监管互动,并与欧盟 AI 法案对齐。

FDA 视角:2025 年草案指南强调验证和风险管理,CDER AI 理事会协调努力。PV 中的 AI 需支持安全评估,使用 FAERS 等工具整合数据。

CIOMS 建议:2025 年草案报告概述原则如以人为本、透明度和鲁棒性,提供 PV 中 AI 验证和伦理使用的最佳实践。

对于企业,合规策略包括:

- 风险评估:根据影响分类 AI Agent(数据提取低风险,因果评估高风险),相应实施控制。

- 验证和监测:使用联邦学习进行隐私合规训练,持续模型更新对抗漂移,并用 XAI 确保透明。

- 人类监督和文档:保留人类审查(如翻译 100% QC),记录架构、数据集和性能以供检查。

- 伦理整合:通过多样数据处理偏差,遵守 GDPR/HIPAA,并聘请伦理专家。

以下表格比较关键机构的监管规范:

| 监管机构 | 关键焦点 | 合规要求 | 工具/指南示例 |

|---|---|---|---|

| EMA | 风险为基础生命周期管理 | 人类监督、可解释性、数据质量 | 反思论文、欧盟 AI 法案 |

| FDA | 创新与安全 | 验证、风险框架、利益相关者输入 | 草案指南、CDER AI 理事会 |

| ICH (GCP) | 试验完整性和参与者保护 | 计算机系统验证、监督 | E6(R3) 指南 |

| CIOMS | PV 专用 AI 原则 | 透明度、鲁棒性、伦理 AI | WG XIV 草案报告 |

图 2:AI 增强 PV 的监管与伦理考虑,突出当前指南及预期演变,强调互联性和全球数据标准化需求。

以下表格摘自相关文献,提供 AI 方法在 ADR 检测中的比较概述(基于多种 PV 数据源,包括社交媒体、EHR 和自发报告系统):

| 数据源 | AI 方法 | 样本大小 | 性能指标 (F 分数/AUC) | 参考 |

|---|---|---|---|---|

| 社交媒体 (Twitter 等) | 条件随机场、Bi-LSTM | 1784 推文至 141,752 药物-ADR 交互 | F 分数 0.66-0.97,AUC 0.76-0.99 | Nikfarjam 等 |

| EHR (临床笔记) | 深度神经网络、梯度提升机 | 变异 | AUC 0.76-0.99 | Li 等、Bae 等 |

| 数据库 (FAERS 等) | 多任务深度学习、BERT | 大型数据集 | 高敏感度和预测值 | Zhao 等、Hussain 等 |

注意,直接比较方法不可行,因数据集性质、大小、任务和评估标准差异。该表概述 AI 应用范围及其报告性能。

挑战与最佳实践

挑战包括算法偏差(例如对少数群体的低性能)、时间漂移、多药联用中的因果推断及数据整合。 最佳实践通过数据增强、持续学习和 XAI 方法(如 SHAP 准确率高达 72%)缓解这些。企业应优先主要来源,寻求 AI 局限的反论,并使用平衡数据集确保公平。

总之,AI Agent 有望推进 PV 并与 GCP 对齐,但其合规使用需严格框架以保障公共健康。

从 CIOMS 报告的额外见解:报告强调风险为基础方法,其中人类监督与风险匹配,确保患者安全。性能评估需在现实条件下验证,结果推广至真实世界设置。透明度通过解释性和生命周期披露实现,支持可追溯性。

Key Citations

- Artificial intelligence in pharmacovigilance: advancing drug safety …

- How AI Agents Power the Next Generation of Pharmacovigilance

- The Future of Agentic AI in Pharmacovigilance: From Automation to …

- Artificial Intelligence in Pharmacovigilance - Working groups - CIOMS

- The Need for Artificial Intelligence in Pharmacovigilance - FDA

- E6(R3) Good Clinical Practice (GCP) September 2025 - FDA

- GUIDELINE FOR GOOD CLINICAL PRACTICE E6(R3) - ICH

- reflection-paper-use-artificial-intelligence-ai-medicinal-product …

- Artificial Intelligence for Drug Development - FDA

- Artificial intelligence in pharmacovigilance - CIOMS

- Regulating the Use of AI in Drug Development: Legal Challenges …

- How Pharma Leaders Are Using AI in Pharmacovigilance to Improve …

- The Effects the ICH E6(R3) Updates Will Have on Good Clinical …

- AI Applications in Pharmacovigilance and Drug Safety | IntuitionLabs

- Applying AI to Structured Real-World Data for Pharmacovigilance …

- DrugSafe AI: The AI Agent Transforming Medication Safety - B EYE

- Pharmacovigilance royalty-free images - Shutterstock

- AI and Signal Detection: An Innovative Approach in … - Linical

- AI Agents vs Workflows in Pharma IT: Technical Comparison